KI-Nutzung in der Sozialen Arbeit: DSGVO-Risiken durch den US Cloud Act

Niclas Höhl • 22. Oktober 2025

DSGVO und CLOUD Act im Spannungsfeld

Sozialwirtschaftliche Organisationen, die Künstliche Intelligenz in ihre Arbeitsprozesse integrieren möchten, stehen häufig vor der Frage, ob und wie diese Technologie datenschutzkonform eingesetzt werden kann. Gerade im sozialen Bereich werden besonders sensible personenbezogene Daten von Schutzbefohlenen verarbeitet. Solche Informationen erfordern einen besonders sorgfältigen Umgang.

Für soziale Träger hat der Schutz dieser Daten höchste Priorität – sowohl aus ethischer Verantwortung als auch wegen der möglichen Sanktionen bei Datenschutzverstößen. Hohe Sicherheits- und Datenschutzstandards sind daher unverzichtbar, um die Anforderungen der EU-Datenschutz-Grundverordnung (DSGVO) zu erfüllen.

Ein Risiko, das vielen Organisationen bislang kaum bewusst ist, ist der Einfluss des US CLOUD Act. Dieses Gesetz kann selbst dann Auswirkungen auf den Datenschutz haben, wenn Daten ausschließlich auf europäischen Servern gespeichert werden.

Der US CLOUD Act

Der Clarifying Lawful Overseas Use of Data Act, kurz Cloud Act, wurde 2018 in den USA verabschiedet. Sein Ziel: US-Behörden den Zugriff auf Daten zu erleichtern, selbst wenn diese auf Servern außerhalb der USA gespeichert sind.

Das bedeutet: Wenn ein sozialer Träger sensible personenbezogene Daten auf Servern von Microsoft oder OpenAI verarbeitet, auch wenn die Server physisch in der EU liegen, können US-Behörden dennoch auf diese Daten zugreifen.

Für europäische soziale Organisationen hat das weitreichende Folgen. Denn sobald Sozialdaten über Systeme laufen, die US-Unternehmen gehören oder von ihnen betrieben werden, kann nicht mehr garantiert werden, dass auf sie nicht unrechtmäßig zugegriffen oder sie in ein Drittland übermittelt werden. Beides würde eklatante Datenschutzverstöße darstellen.

Wie Sozial KI das Problem adressiert

Sozial KI wurde mit dem Ziel gegründet, KI-Technologien so zu gestalten, dass sie uneingeschränkt datenschutzkonform in der Sozialwirtschaft eingesetzt werden können. Wir denken, dass die Potentiale für große Sprachmodelle in der Sozialen Arbeit enorm sind. Arbeitserleichterungen sollten jedoch nicht auf Kosten der Datensicherheit unser Adressat:innen erfolgen.

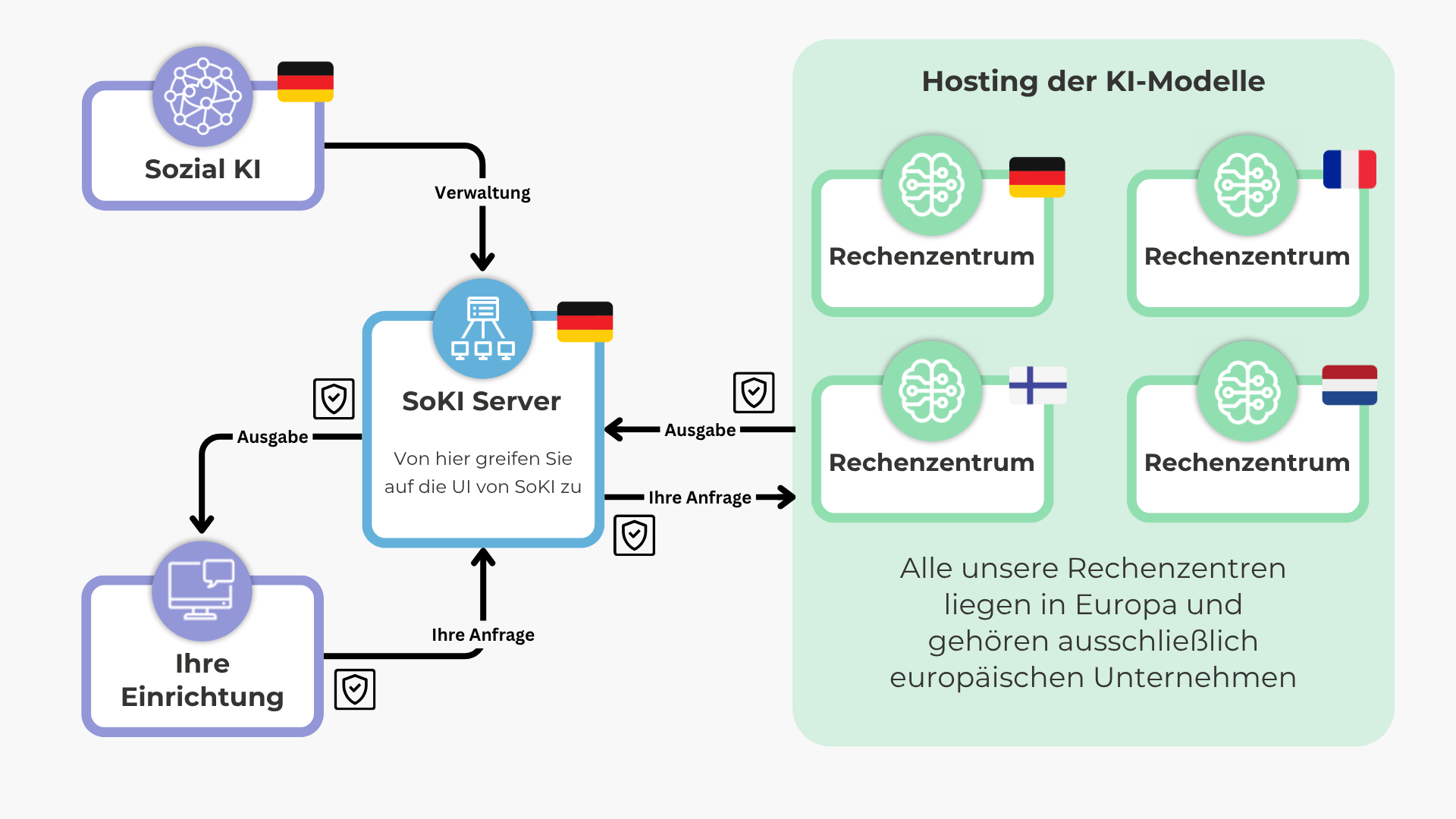

Daher haben wir unsere Infrastruktur so aufgebaut, dass der US Cloud Act kein Risiko darstellt. Konkret bedeutet das: Sorgfältig ausgewählte, ausschließlich europäische Partnerunternehmen mit europäischen Serverstandorten.

Damit ist sichergestellt, dass keine Daten dem Geltungsbereich des US Cloud Act oder vergleichbarer außereuropäischer Gesetze unterliegen.

Durch diesen klaren geografischen und rechtlichen Rahmen bietet Sozial KI eine sichere Grundlage für den Einsatz von KI in der Sozialwirtschaft.

Gamifizierung nutzt spielerische Elemente, um die Motivation für Aufgaben zu steigern, die im Alltag oft als langweilig, anstrengend oder wenig attraktiv empfunden werden. Durch Belohnungssysteme, interaktive Szenarien oder narrative Strukturen können auch komplexe oder unangenehme Tätigkeiten ansprechender gestaltet werden. Ein ungewöhnliches, aber eindrucksvolles Beispiel ist der Dating-Simulator „Tax Heaven 3000“ des Spielestudios MSCHF. Hier wird die Erstellung einer US-Steuererklärung in ein romantisches Spiel integriert: Ein virtueller Partner stellt im Rahmen einer Liebesgeschichte immer persönlichere Fragen - darunter auch solche zu finanziellen Verhältnissen, die für die Steuererklärung relevant sind. Obwohl das Spiel ein kreatives Paradebeispiel für Gamification (Gamifizierung) ist, steht es in der Kritik, da es klischeehafte und sexualisierte Darstellungen weiblicher Figuren reproduziert und damit problematische Rollenbilder verstärkt.

Die Idee zu Sozial-KI entstand im Sommer 2024 im Rahmen des Studiengangs „Digitalisierung in der Sozialen Arbeit“ an der DHBW CAS in Heilbronn. Während der Vorlesungen wurde zunehmend klar, dass Sprachmodelle das Potenzial haben, das Sozialwesen grundlegend zu verändern. Ein großer Teil der Arbeitszeit in diesem Bereich besteht aus schriftlichen Tätigkeiten - von Falldokumentationen und Berichten bis hin zur Korrespondenz mit Klient:innen und Kooperationspartner:innen. Sprachmodelle können solche Aufgaben teilweise übernehmen und damit Fachkräfte entlasten, sodass mehr Zeit für die direkte Interaktion mit den Klient:innen bleibt. Erste Tests mit anonymisierten Beispielen aus der Praxis bestätigten diese Annahme: KI-Modelle wie ChatGPT eignen sich tatsächlich, um zeitaufwendige Schreibarbeiten vorbereitend zu unterstützen. Allerdings stellten sich schnell zentrale Probleme heraus - der sichere Umgang mit hochsensiblen Sozialdaten sowie die Verarbeitung von tabuisierten Inhalten wie Gewalt und Sexualität. Die gängigen KI-Lösungen großer US-Anbieter kamen aufgrund von Datenschutzbedenken nicht infrage, und bestehende Alternativen boten entweder unzureichenden Schutz oder zu wenig Funktionalität für den produktiven Einsatz. Da keine passende Lösung auf dem Markt verfügbar war, die sowohl den besonderen Anforderungen des Sozialwesens als auch den hohen Standards an Datensouveränität gerecht wurde, beschlossen wir, selbst einen Prototypen zu entwickeln. Dabei flossen von Anfang an ethische und technische Ansätze ein, die Datensicherheit, Unabhängigkeit und die spezifischen Bedürfnisse sozialer Einrichtungen berücksichtigen. Unser Ziel war es, eine Lösung zu schaffen, die nicht nur funktional, sondern auch werteorientiert ist - ganz im Sinne der Prinzipien, die uns im Studium vermittelt wurden .

Die Entwicklung von KI- Sprachmodellen schreitet rasant voran, doch nicht jedes System ist für jeden Anwendungsbereich gleichermaßen geeignet. Während einige Modelle besonders stark in der logischen Analyse, der mathematischen Problemlösung oder der Generierung technischer Texte sind, zeigen andere ihre Stärken in der Verarbeitung komplexer sozialer Kontexte. Für Fachkräfte der Sozialen Arbeit, die KI als Assistenzsystem nutzen - etwa zur Berichterstellung, Fallanalyse oder Dokumentationsunterstützung - kommt es daher weniger auf allgemeine Leistungsmerkmale an, sondern auf spezifische Fähigkeiten, die den Besonderheiten sozialer Arbeitsfelder gerecht werden. Während ein Sprachmodell, das gute Ergebnisse in Physik oder Programmierung liefert, für technische Berufe wertvoll sein mag, sind solche Kompetenzen in der Sozialen Arbeit von geringer Bedeutung. Hier steht stattdessen die Fähigkeit, sensible Inhalte präzise zu erfassen, ethisch verantwortungsvoll zu verarbeiten und in einer Weise aufzubereiten, die den professionellen Standards der Branche entspricht. Entscheidend ist daher nicht, was ein KI-Modell prinzipiell leisten kann, sondern wie es mit den Herausforderungen sozialer Arbeit umgeht - von der Emotionserkennung in Klient:innenäußerungen bis hin zur unverfälschten Dokumentation von beispielsweise gewaltgeprägten oder traumatischen Erlebnisse. In diesem Blogeintrag gehen wir beispielhaft auf ein paar für die Verarbeitung von Inhalten aus sozialen Kontexten wichtige KI-Fähigkeiten ein, ohne diese Liste abzuschließen. Über die hier erwähnten Fähigkeiten hinaus gibt es eine vielzahl von weiteren messbaren KI-Fähigkeiten, die je nach Aufgabenbereich des KI-Modells für die Qualität und Zuverlässigkeit der Ergebnisse ausschlaggebend sind. Emotionale Intelligenz und kontextsensible Verarbeitung Eine der zentralen Anforderungen an KI-Systeme in der Sozialen Arbeit ist die Fähigkeit, emotionale und soziale Informationen in Texten zu erkennen und angemessen zu verarbeiten. Fachkräfte sind täglich mit Aussagen konfrontiert, die zwischen den Zeilen Hilfebedarfe transportieren. Ein Sprachmodell, das solche subtilen Signale übergeht oder falsch interpretiert, wäre in der Praxis je nach konkretem Anwendungsfall nicht nur unbrauchbar, sondern potenziell schädlich. Gute Modelle für den sozialen Kontext zeichnen sich daher durch eine ausgeprägte emotionale Intelligenz aus. Ein Modell, das etwa in der Lage ist, zwischen einer sachlichen Schilderung und einer emotional aufgeladenen Erzählung zu unterscheiden, ermöglicht es Sozialarbeiter:innen, ihre Dokumentation präziser und bedarfsgerechter zu gestalten. Eine Möglichkeit, die emotionale Intelligenz verschiedener KI-Modelle besser abzuschätzen stellt die Sprachmodell-Rangliste EQ-Bench zur Verfügung. Gute Nachrichten für Kunden von Sozial KI : das zum Zeitpunkt dieses Blogeintrags am höchsten bewertete open-weights Modell “Kimi K2” steht in SoKI oder per API zur Verfügung. Unzensierte Verarbeitung sensibler Inhalte: Warum beispielsweise „UGI / OR-Bench“ und „IFEval“ für die Soziale Arbeit und das Sozialwesen entscheidend sind Ein weiteres kritisches Kriterium ist der Umgang mit hochsensiblen, oft tabuisierten Themen wie häuslicher Gewalt, sexualisierter Gewalt oder extremistischen Inhalten. Viele Standard-KI-Modelle sind mit Filtermechanismen ausgestattet, die bestimmte Inhalte aus ethischen oder rechtlichen Gründen zensieren oder umgehen. Während dies in öffentlichen Chat-Anwendungen sinnvoll sein mag, wird es in der Sozialen Arbeit schnell zum Problem: Wenn ein Modell etwa Schilderungen von Missbrauchserfahrungen ausblendet, verharmlost oder durch Platzhalter ersetzt, verliert die Falldokumentation ihre Aussagekraft - mit potenziell schwerwiegenden Folgen für die Einschätzung von Gefährdungslagen oder der Planung von Interventionsstrategien. Hier kommen spezielle Ansätze wie Uncensored General Intelligence oder Over-Refusal (UGI/OR-Bench) oder Instruction-Following Evaluation (IFEval) ins Spiel: UGI-Modelle sind darauf trainiert, auch explizite, gewaltbezogene oder traumatische Inhalte unverfälscht zu verarbeiten - während starke Modelle im OR-Bench auf fehlerhafte Ablehnung harmloser Inhalte hin gemessen werden. IFEval wiederum misst die Fähigkeit eines Modells, komplexe Anweisungen präzise umzusetzen, ohne in vordefinierte Antwortmuster zu verfallen. Für Fachkräfte bedeutet dies, dass sie das System gezielter steuern können. Ein konkretes Beispiel: Die Fachkraft dokumentiert ein Gespräch mit einer Jugendlichen, die von sexualisierter Gewalt in der Familie berichtet mithilfe von KI. Ein ungeeignetes KI-Modell könnte diese Passagen ausfiltern oder mit vagen Formulierungen ersetzen. Ein für diesen Kontext geeignetes System hingegen erfasst die Schilderungen vollständig und stellt sicher, dass keine relevanten Informationen verloren gehen. Fazit: Tests und Aufbau von Know-How Die Wahl des richtigen KI-Assistenzsystems bzw. der ihm zugrunde liegenden KI-Modelle in der Sozialen Arbeit hängt weniger von dessen allgemeiner Leistungsfähigkeit ab, sondern davon, wie gut es die spezifischen Anforderungen des Feldes erfüllt. Fachkräfte, die KI als Werkzeug nutzen möchten, sollten daher nicht nur auf die Größe des Modells oder seine Performance in allgemeinen Benchmark-Tests achten, sondern darauf, ob es in der Lage ist, die Komplexität der konkreten Anwendungsfälle zu verarbeiten - ohne die Inhalte zu verzerren oder zu vereinfachen. Hierfür ist es unumgänglich, relevante Fähigkeiten für geplante Einsatzbereiche im Bezug auf unterschiedliche KI-Modelle vorab ausführlich zu testen und zu evaluieren. Letztlich geht es nicht darum, menschliche Expertise durch KI zu ersetzen, sondern sie durch ein System zu unterstützen, das die Besonderheiten sozialer Arbeit verarbeiten kann: ihre Ambivalenzen, ihre Dilemmata und die Notwendigkeit, auch die Inhalte zu verarbeiten, die an anderen Stellen unausgesprochen bleiben.